Η AI πλησιάζει τρομακτικά πιο κοντά στα δεδομένα από το Star Trek: TNG τώρα που γνωρίζει αν μπορείτε ή όχι να το εμπιστευτείτε

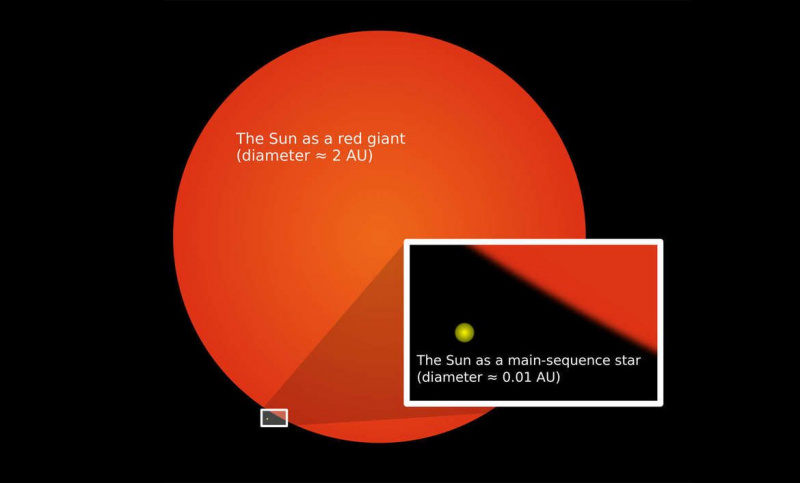

>Μπορεί να μην είναι τόσο αυτοσυνείδητο όσο τα δεδομένα από Star Trek: TNG (ακόμα), ειδικά επειδή αυτό το droid θα μπορούσε να φροντίσει καλύτερα μια γάτα από κάποιους ανθρώπους, αλλά η τεχνητή νοημοσύνη έχει φτάσει τώρα στο σημείο να συνειδητοποιεί πότε δεν είναι αξιόπιστη.

Αυτό που λέγεται τώρα βαθιά αποδεικτική παλινδρόμηση έχει ισοπεδώσει την αυτογνωσία του AI. Θα γνωρίζει πότε έχει μεγαλύτερη πιθανότητα να κάνει λάθος στην πρόβλεψη, με βάση την αξιολόγηση της αξιοπιστίας των δεδομένων που εξετάζει. Οι μελλοντικές προβλέψεις είναι πιο πιθανό να λειτουργήσουν εάν επηρεαστούν από πιο εμπεριστατωμένα και ακριβή δεδομένα. Το αντίθετο σημαίνει ότι τα πράγματα πιθανότατα θα πάνε στραβά - και το AI μπορεί να το αντιληφθεί. Όταν εκτιμά τη βεβαιότητά του για κάτι, αυτή η βεβαιότητα θα ανεβαίνει και κατεβαίνει ανάλογα με τα δεδομένα που τροφοδοτείται. Το AI μπορεί στη συνέχεια να προσδιορίσει τον κίνδυνο ή την αβεβαιότητα με ακρίβεια 99%.

Φαίνεται ότι ακόμη και ο Picard θα εντυπωσιαστεί - αλλά περιμένετε. Υπάρχει μόνο ένα μειονέκτημα στα ρομπότ με αυτογνωσία, και αυτό είναι ότι το 99% δεν είναι απόλυτη βεβαιότητα, ανεξάρτητα από το πόσο κοντά είναι. Η απουσία μόλις 1% θα μπορούσε να σημαίνει καταστροφή σε δυνητικά απειλητικά για τη ζωή σενάρια, από την οδήγηση ενός αυτόνομου αυτοκινήτου έως την επέμβαση. Τρομακτικός.

Ενώ η [βαθιά αποδεικτική παλινδρόμηση] παρουσιάζει αρκετά πλεονεκτήματα έναντι των υφιστάμενων προσεγγίσεων, οι κύριοι περιορισμοί της είναι στη ρύθμιση του συντελεστή κανονικοποίησης και στην αποτελεσματική αφαίρεση μη παραπλανητικών στοιχείων κατά τη βαθμονόμηση της αβεβαιότητας, είπε το MIT Ph.D. μαθητής Αλέξανδρος Αμίνης , ο οποίος ηγήθηκε μιας μελέτης που θα παρουσιάσει στο συνέδριο του NeurIPS τον επόμενο μήνα.

Αυτό που κατάφερε να κάνει ο Αμίνι και η ομάδα του είναι ακόμα αξιοσημείωτο. Πριν από αυτό, η χρήση τεχνητής νοημοσύνης για την εκτίμηση της αβεβαιότητας δεν ήταν μόνο δαπανηρή, αλλά πολύ αργή για αποφάσεις που πρέπει να ληφθούν σε κλάσματα του δευτερολέπτου. Τα νευρωνικά δίκτυα μπορεί να είναι τόσο τεράστια που μπορεί να χρειαστεί για πάντα για να υπολογίσουν μια απάντηση και η αναμονή για να μάθουν το επίπεδο εμπιστοσύνης θα ήταν πολύ μεγάλη για να μπουν στον κόπο να καταβάλουν προσπάθεια. Θα ήταν άσκοπο να χρησιμοποιηθεί κάτι τέτοιο σε έναν εαυτό -οδήγηση αυτοκινήτου που πρέπει να γνωρίζει ποια στροφή θα κάνει αμέσως. Η διαδικασία προωθήθηκε γρήγορα με βαθιά αποδεικτική παλινδρόμηση. Αυτό το νευρωνικό δίκτυο χρειάζεται μόνο μία φορά για να μάθει το επίπεδο αβεβαιότητας.

Μαντεύοντας την αβεβαιότητα σε ένα μοντέλο που έχει ήδη μάθει η τεχνητή νοημοσύνη, μπορεί να μας πει πόσο μεγάλο είναι το περιθώριο σφάλματος. Το AI χρησιμοποιεί στοιχεία για να στηρίξει την εκτίμησή του. Αυτά τα στοιχεία περιλαμβάνουν οποιαδήποτε αβεβαιότητα που είτε κρύβεται στα δεδομένα που μόλις αναλύθηκαν από το νευρωνικό δίκτυο είτε την αυτογνωσία του για το πόσο σίγουρος είναι για τη δική του απόφαση. Ο Amini και η ομάδα του δοκίμασαν τη μέθοδο της βαθιάς αποδεικτικής παλινδρόμησης εκπαιδεύοντας την AI να εκτιμήσει το βάθος κάθε εικονοστοιχείου σε μια εικόνα. Η αντίληψη βάθους θα μπορούσε να σημαίνει ζωή ή θάνατο σε μια χειρουργική επέμβαση που πρέπει να αφαιρέσει έναν όγκο που μπορεί να βρίσκεται βαθιά μέσα στο σώμα και είναι δύσκολο να δει διαφορετικά.

Το AI ήταν ως επί το πλείστον ακριβές, αλλά μπερδεύτηκε μια φορά τροφοδοτήθηκε με εικόνες που ήταν πιο δύσκολο να θυμηθούμε. Τουλάχιστον υπήρχε ένα πράγμα για το οποίο ήταν συνεπές: Όταν αντιμετώπιζε εικόνες που της έδιναν δυσκολία, ενημέρωνε την ομάδα για την αβεβαιότητά της χωρίς αποτυχία. Το καθορισμένο περιθώριο σφάλματος μπορεί τουλάχιστον να διδάξει στους ερευνητές πώς να βελτιώσουν αυτό το μοντέλο. Η ικανότητά του να αναγνωρίζει εικόνες που είχαν υποβληθεί σε Photoshop ανοίγει επίσης τη δυνατότητα αναγνώρισης των deepfakes. Οι άνθρωποι πρέπει απλώς να γνωρίζουν ότι αυτός ο εγκέφαλος ρομπότ είναι ακόμα εσφαλμένος και δεν μπορούμε να τον εμπιστευτούμε περισσότερο από όσο μπορεί να εμπιστευτεί τον εαυτό του.

Πιστεύουμε ότι απαιτείται περαιτέρω έρευνα για να ανακαλυφθούν εναλλακτικοί τρόποι για την αφαίρεση μη παραπλανητικών στοιχείων, Είπε ο Αμίνι .

Δηλαδή, η τεχνητή νοημοσύνη που μπορεί να σκεφτεί χρησιμοποιώντας βαθιά αποδεικτική παλινδρόμηση είναι αρκετά αξιόπιστη, εφόσον το αποτέλεσμα μιας λανθασμένης απάντησης δεν θα ήταν θανατηφόρο.